Qu'est-ce que la mise en cache ?

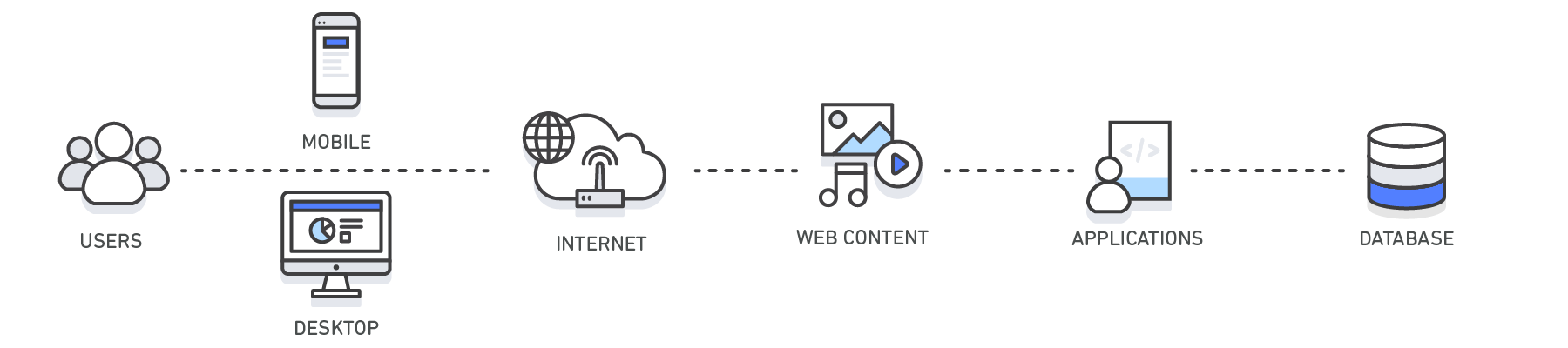

En informatique, un cache est une couche de stockage de données grande vitesse qui stocke un sous-ensemble de données, généralement transitoires, de sorte que les demandes futures pour ces données sont traitées le plus rapidement possible en accédant à l'emplacement de stockage principal des données. La mise en cache vous permet de réutiliser efficacement des données précédemment récupérées ou traitées.

Comment fonctionne la mise en cache ?

Les données mises en cache sont généralement stockées sur du matériel à accès rapide comme de la RAM (mémoire vive) et peuvent également être utilisées en corrélation avec un composant logiciel. L'objectif principal d'un cache est d'augmenter les performances de récupération des données en réduisant le besoin d'accès à la couche de stockage sous-jacente plus lente.

En laissant la capacité au profit de la vitesse, un cache stocke généralement un sous-ensemble de données transitoires, contrairement aux bases de données dont les données sont généralement complètes et durables.

Présentation de la mise en cache

| Couche | Côté client | DNS | Web | Application | Base de données |

| Cas d'utilisation | Accélérer la récupération du contenu Web à partir de sites Web (navigateur ou appareil) |

Domaine pour résolution d'IP | Accélérer la récupération de contenu Web depuis des serveurs Web/d'application. Gérer les sessions Web (côté serveur) | Accélérer les performances d'application et l’accès aux données | Réduire la latence associée à des requêtes d'interrogation de base de données |

| Technologies | En-têtes de cache HTTP, navigateurs | Serveurs DNS | En-têtes de cache HTTP, CDN, proxys inversés, accélérateurs Web, magasins de clés/valeurs | Magasins de données de clés/valeurs, caches locaux | Mémoires tampons de bases de données, magasins de données de clés/valeurs |

| Solutions | Propre au navigateur | Amazon Route 53 | Amazon CloudFront, ElastiCache for Redis, ElastiCache for Memcached, Solutions de partenaires | Frameworks d'application, ElastiCache for Redis, ElastiCache for Memcached, Solutions de partenaires | ElastiCache for Redis, ElastiCache for Memcached |

Mise en cache avec Amazon ElastiCache

Amazon ElastiCache est un service Web qui facilite le déploiement, l’utilisation et la mise à l’échelle d’un magasin ou cache de données en mémoire dans le cloud. Ce service améliore les performances des applications web en vous permettant de récupérer des informations depuis des magasins de données en mémoire gérés rapides, au lieu de vous en remettre entièrement à des bases de données sur disques, qui sont plus lentes. Découvrez comment mettre en place une stratégie de mise en cache efficace avec ce livre blanc technique sur la mise en cache en mémoire.